有機(jī)搜索已成為我們?nèi)粘I钪胁豢苫蛉钡囊徊糠帧W罱臄?shù)據(jù)顯示,近30% 的全球網(wǎng)絡(luò)流量來(lái)自在線搜索。?搜索引擎每天抓取和索引數(shù)十億的網(wǎng)絡(luò)內(nèi)容,根據(jù)相關(guān)性(它們與搜索查詢的相關(guān)程度)在搜索結(jié)果中對(duì)它們進(jìn)行排名,從而使它們可供公眾使用。您可以使用 robot.txt 文件設(shè)置有關(guān)您希望搜索引擎如何抓取和向公眾顯示您的 Web 內(nèi)容的指令。本文將向您介紹您需要了解的有關(guān) robots.txt 文件的所有信息。

了解 Robot.txt 文件

搜索索引從簡(jiǎn)單的搜索引擎抓取開(kāi)始。robots.txt 文件,也稱為Robots Exclusion Protocol?,指示搜索機(jī)器人抓取網(wǎng)站——去哪里和不去哪里。用戶經(jīng)常使用該文件來(lái)指定搜索引擎不應(yīng)抓取的頁(yè)面。

當(dāng)搜索引擎通過(guò)鏈接或站點(diǎn)地圖發(fā)現(xiàn)網(wǎng)站時(shí),它會(huì)打開(kāi)網(wǎng)站的 robots.txt 文件以了解要抓取的頁(yè)面和不應(yīng)該抓取的頁(yè)面。爬蟲(chóng)會(huì)緩存 robots.txt 文件,以免每次訪問(wèn)網(wǎng)站時(shí)打開(kāi)它。緩存文件每次自動(dòng)刷新數(shù)次,定期保持更新。

robots.txt 區(qū)分大小寫并位于域的根目錄下,例如www.domain.com/robots.txt。

為什么 Robots.txt 文件很重要

為您的網(wǎng)站創(chuàng)建一個(gè) robot.txt 文件有很多好處;例如,您可以使用它來(lái)管理您的抓取預(yù)算。搜索蜘蛛通常有預(yù)定數(shù)量的可以在網(wǎng)站上抓取的頁(yè)面或在網(wǎng)站上花費(fèi)的時(shí)間。如果您管理一個(gè)擁有數(shù)千個(gè)頁(yè)面的網(wǎng)站,您可以阻止不重要的頁(yè)面以最大化抓取預(yù)算。

使用 robots.txt 文件的其他好處包括:

- 它可以幫助網(wǎng)絡(luò)管理員控制搜索引擎可以訪問(wèn)的網(wǎng)頁(yè)。

- 該文件使用戶可以完全自由地阻止特定機(jī)器??人抓取他們的網(wǎng)站。

- 該文件有助于防止敏感內(nèi)容被編入索引。

- 您可以使用它來(lái)阻止索引不必要的文件,例如圖像、PDF 和視頻。

使用 Robots.txt 文件提高可抓取性

現(xiàn)在,如何使用 robots.txt 文件提高網(wǎng)站的可抓取性?當(dāng)然,讓我們找出答案。

Robots.txt 語(yǔ)法

機(jī)器人文件包含一個(gè)或多個(gè)搜索引擎指令塊,第一行指定用戶代理——您向其提供爬行指令的搜索蜘蛛的名稱。

基本的 robots.txt 文件如下所示:

站點(diǎn)地圖:https://yourdomain.com/sitemap_index.xml

用戶代理: *

不允許:/*?comments=all

不允許:/wp-content/themes/user/js/script-comments.js

不允許:/wp-comments-post.php

不允許:/go/

用戶代理:Googlebot

不允許:/登錄

用戶代理:bingbot

不允許:/照片

上面的 robots.txt 文件包含三個(gè)指令塊——第一個(gè)指令是針對(duì)所有用戶代理的,第二個(gè)指令是針對(duì)Google 爬蟲(chóng)的,第三個(gè)是針對(duì) Bing 機(jī)器人的。

以下是這些術(shù)語(yǔ)的含義:

- Sitemap指定了網(wǎng)站站點(diǎn)地圖的位置,它列出了一個(gè)網(wǎng)站中的所有頁(yè)面,方便爬蟲(chóng)查找和爬取。您還可以將站點(diǎn)地圖放在 robots.txt 文件的末尾。

- 如前所述,用戶代理指的是您希望向其發(fā)送指令的搜索機(jī)器人。使用星號(hào) (*) 通配符將指令分配給所有用戶代理,但您可以使用正確的名稱指定用戶代理。

- Disallow指示用戶代理不抓取指定的 URL。您可以將該行留空以指定您不允許任何內(nèi)容。

Allow指令指示機(jī)器人抓取指定的URL,即使先前的指令不允許其目錄,下面是一個(gè)示例。

用戶代理: *

不允許:/wp-admin/

允許:/wp-admin/admin-ajax.php

robots.txt 文件阻止了wp-admin目錄,該目錄包含敏感的 WordPress 文件,包括插件和主題,但允許蜘蛛爬行和索引目錄中的admin-ajax.php文件。

crawl-delay指令 (?crawl-delay: 10 ) 告訴用戶代理在抓取頁(yè)面之前等待指定的秒數(shù)(例如,十秒)。

該指令告訴搜索引擎更改抓取頁(yè)面的頻率,從而幫助您節(jié)省帶寬。不幸的是,Google 不再識(shí)別該指令,但 yahoo 和 Bing 仍然識(shí)別。

用戶代理指令

大多數(shù)搜索引擎都有不同的爬蟲(chóng)用于不同的目的。例如,一些搜索引擎有用于正常索引、圖像和視頻的蜘蛛,而像 Bing 這樣的一些搜索引擎甚至有用于他們的廣告程序的蜘蛛。

因此,我們按字母順序整理了一張目前可用的所有常見(jiàn)用戶代理的表格。

讓我們來(lái)看看。

| 序列號(hào) | 搜索引擎 | 機(jī)器人類型 | 用戶代理 |

| 1 | 百度 | 一般索引 | 百度蜘蛛 |

| 2 | 百度 | 圖片 | 百度蜘蛛圖片 |

| 3 | 百度 | 移動(dòng)索引 | baiduspider-mobile |

| 4 | 百度 | 消息 | 百度蜘蛛新聞 |

| 5 | 百度 | 影片 | 百度蜘蛛視頻 |

| 6 | Bing | 一般的 | 冰棒 |

| 7 | Bing | 一般的 | 微信機(jī)器人 |

| 8 | Bing | 圖片和視頻 | 微軟媒體 |

| 9 | Bing | 廣告 | adidxbot |

| 10 | 谷歌 | 一般的 | 谷歌機(jī)器人 |

| 11 | 谷歌 | 圖片 | Googlebot 圖片 |

| 12 | 谷歌 | 移動(dòng)的 | Googlebot-移動(dòng)版 |

| 13 | 谷歌 | 消息 | Googlebot-新聞 |

| 14 | 谷歌 | 視頻 | Googlebot-視頻 |

| 15 | 谷歌 | AdSense | Mediapartners-谷歌 |

| 16 | 谷歌 | 廣告 | AdsBot - 谷歌 |

| 17 | 雅虎 | 一般的 | 啜飲 |

| 18 | Yandex | 一般的 | yandex |

用戶代理區(qū)分大小寫,因此在設(shè)置 robots.txt 文件時(shí)請(qǐng)正確使用名稱。

設(shè)置抓取指令

讓我們探討一些可以使用 robots.txt 文件無(wú)縫抓取網(wǎng)站的方法。

抓取整個(gè)網(wǎng)站

您可以設(shè)置 robots.txt 文件以允許所有搜索機(jī)器人對(duì)您的整個(gè)網(wǎng)站進(jìn)行爬網(wǎng)和索引。如果您的網(wǎng)站上有私人或敏感文件,我們不建議這樣做。

但是,要提供此指令,請(qǐng)將以下行添加到您的 robots.txt 文件中。

用戶代理: *

不允許:

但是如果你希望只允許選定的蜘蛛爬行和索引整個(gè)網(wǎng)站,那么指定用戶代理,當(dāng)然,每個(gè)用戶代理一個(gè)指令塊。

阻止整個(gè)網(wǎng)站

為防止搜索引擎抓取您的網(wǎng)站并將其編入索引,尤其是在您重新設(shè)計(jì)網(wǎng)站時(shí),您可以阻止整個(gè)網(wǎng)站被編入索引。??將此指令添加到您的 robots.txt 文件以完成它。

用戶代理: *

不允許: /

為防止機(jī)器人抓取您的網(wǎng)站,請(qǐng)指定用戶代理。

阻止選定的部分

要阻止網(wǎng)站的特定部分,請(qǐng)為文件夾或頁(yè)面設(shè)置禁止指令,這是一個(gè)示例。

用戶代理: *

不允許:/視頻

該指令阻止所有蜘蛛抓取視頻目錄及其中的所有內(nèi)容。您還可以使用通配符 (*) 和 ($) 等正則表達(dá)式來(lái)阻止文件組。不幸的是,大多數(shù)搜索引擎不識(shí)別后者,包括谷歌。

但是這里介紹如何使用正則表達(dá)式來(lái)阻止一組文件。

不允許:圖片/*.jpg

不允許:/*php?$

通配符 (*) 阻止圖像目錄中文件名中包含.jpg的文件,而 ($) 阻止所有以.php結(jié)尾的文件。

請(qǐng)注意,disallow、allow 和 user-agent 值區(qū)分大小寫。在我們上面的兩個(gè)例子中,搜索蜘蛛將阻止:

- ?視頻目錄,但不會(huì)阻止/videos

- /images/beach.jpg但會(huì)抓取/images/beach.JPG

Robot.txt 文件對(duì)比。無(wú)索引標(biāo)簽

robots.txt 文件指示蜘蛛不要抓取頁(yè)面,但如果許多網(wǎng)站鏈接它,可能不會(huì)阻止搜索引擎索引該頁(yè)面。如果搜索引擎發(fā)現(xiàn)足夠多的指向該頁(yè)面的外部鏈接,它會(huì)在不知道其內(nèi)容的情況下對(duì)該頁(yè)面進(jìn)行索引,從而為您提供如下所示的搜索結(jié)果:

![]()

但是您可以將Noindex 指令添加到您的 robots.txt 文件中,以防止這些文件出現(xiàn)在搜索結(jié)果中。

用戶代理: *

不允許:/視頻

無(wú)索引:/視頻

您還可以將 meta robots?noindex標(biāo)記添加到頁(yè)面的標(biāo)題中,以可靠地防止搜索引擎對(duì)其進(jìn)行索引。如果您使用此選項(xiàng),請(qǐng)避免阻止帶有 robots.txt 的頁(yè)面以使蜘蛛程序能夠找到標(biāo)簽。

生成 Robot.txt 文件

您可以使用一些直觀的在線工具為您的網(wǎng)站生成一個(gè) robots.txt 文件,這里只有五個(gè):

- 早上的 Robots.txt 生成器

- SureOak Robots.txt 文件生成器

- SEOptimer 免費(fèi) Robots.txt 生成器

- SEO PowerSuite Robots.txt 生成器工具

- SEOBook Robots.txt 文件生成器

將 Robots.txt 文件添加到您的域

您可以通過(guò)帳戶控制面板將新創(chuàng)建的 robots.txt 添加到您的域,方法如下。

第 1 步:訪問(wèn)您的帳戶控制面板

通過(guò)登錄 SPanel 訪問(wèn)您帳戶的控制面板。訪問(wèn)www.domain.com/spanel/login?,將domain.com替換為您的域名。

輸入您的登錄憑據(jù)以登錄。

如果您以管理員身份登錄,則 SPanel 會(huì)將?您帶到您的管理儀表板,但用戶訪問(wèn)會(huì)將您登錄到控制面板。在管理儀表板上,滾動(dòng)到QUICK LINKS并單擊List Accounts?。

單擊您希望訪問(wèn)其控制面板的帳戶的“操作”按鈕,然后從上拉菜單中選擇“登錄”以獲取訪問(wèn)權(quán)限。

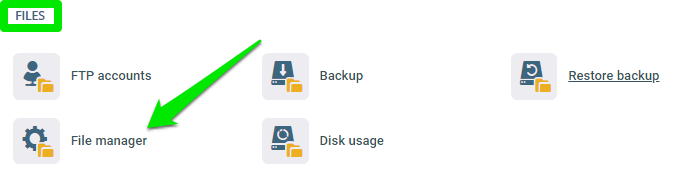

第 2 步:打開(kāi)文件管理器

在控制面板上,單擊文件部分下的文件管理器。

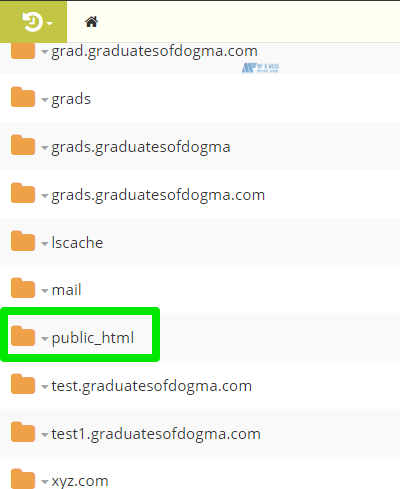

打開(kāi)您網(wǎng)站的基本目錄或根目錄。根域使用public_html文件夾作為其根目錄。

第 3 步:創(chuàng)建 Robots.txt 文件

在根目錄中,單擊新建文件/文件夾圖標(biāo)并選擇新建文件。

將新文件命名為robots.txt不帶大寫,然后單擊確定保存

編寫您的爬網(wǎng)指令或?qū)⑺鼈儚?fù)制并粘貼到空白文件中并保存。

而已。

把它包起來(lái)

當(dāng)您發(fā)布 robots.txt 文件時(shí),請(qǐng)使用Google robots.txt 測(cè)試器工具來(lái)驗(yàn)證抓取指令,以確保您不會(huì)錯(cuò)誤地禁止您不打算阻止的頁(yè)面。